hadoop查看数据(hadoop怎么查看hdfs)

本篇目录:

1、linux中如何查看hadoop文件中的数据2、hadoop怎么查看每个目录的路径3、请教如何在hadoop获取数据4、如何利用nutch和hadoop爬取网页数据linux中如何查看hadoop文件中的数据

namenode就是master。 必须要有一台启动namenode服务。 === 如果只需要 datanode,那么jps 命令后,查看到线程ID 然后kill 掉就好了。 注意 kill掉 namenode后,整个hadoop集群就宕掉了。

find命令find是linux下用于查找文件的通用方法。find语法:find例如:find/tmp-namewa*-typel,是在/tmp下查找名为wa开头且类型为符号链接的文件。找到就表示存在。

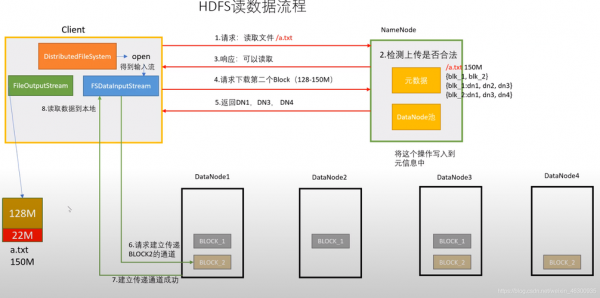

HDFS:HDFS是Hadoop的分布式文件系统,用于存储大规模数据集。它通过将文件切分成块(Block)并存储在不同的数据节点上来实现分布式存储。

首先打开linux系统,进入到图形界面中去:然后右键在桌面点击,点击桌面菜单中的终端,打开终端端口:最后输入命令“ls~|wc-w”,其中wc用来计算统计文件的数据,回车后即可看到目录数。

【答案】:B (1)-S 排序 –i 表示inode,显示文件索引号 –a all意思,-l 表示长格式,可以看到详细文件信息。

df命令:用于显示文件系统的磁盘空间使用情况,包括已用空间、可用空间、文件系统类型等。示例命令:`df -h` du命令:用于显示目录或文件的磁盘使用情况,可以查看各个子目录或文件的大小。

hadoop怎么查看每个目录的路径

1、core-site.xml文件位于$HADOOP_HOME/etc/hadoop路径下,配置了hadoop数据存放路径,包括namenode、datanode、journalnode的相关数据。

2、当需要查找文件时,HDFS会根据文件名和路径信息进行索引,在元数据中快速定位文件所在的数据节点。通过这种方式,HDFS能够高效地进行文件的查找和访问。 MapReduce:MapReduce是Hadoop的计算模型和处理框架。

3、需要注意的是,临时文件夹路径可能因为不同的Hadoop版本、配置和环境而有所不同。如果需要查看具体的路径,可以在Hadoop配置文件中查找相关的参数配置,例如mapred-site.xml文件中的mapred.local.dir参数。

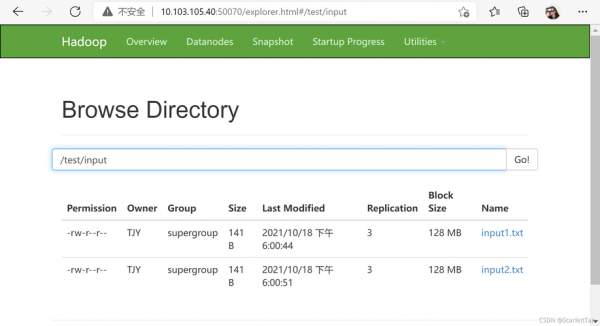

4、也可以直接去某一个DataNode查看目录:hadoop.tmp.dir/dfs/data/current就可以看到那些block了。Block的数量将会直接影响到Map的个数。当然可以通过配置来设定Map和Reduce的任务个数。

请教如何在hadoop获取数据

1、当需要查找文件时,HDFS会根据文件名和路径信息进行索引,在元数据中快速定位文件所在的数据节点。通过这种方式,HDFS能够高效地进行文件的查找和访问。 MapReduce:MapReduce是Hadoop的计算模型和处理框架。

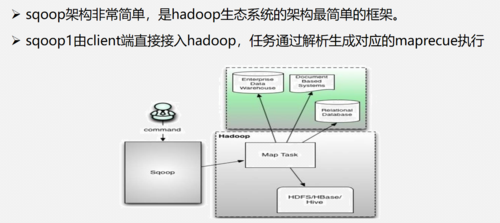

2、Hadoop的Mapper是怎么从HDFS上读取TextInputFormat数据的 Hadoop中控制文件格式,split方式和record读取方式的类都继承自InputFormat这个抽象类。

3、在【数据库名称】文本框中输入要新建数据库的名称。例如,这里以“新建的数据库”。在【所有者】文本框中输入新建数据库的所有者,如sa。根据数据库的使用情况,选择启用或者禁用【使用全文索引】复选框。

4、Nutch是什么?Nutch是一个开源的网页抓取工具,主要用于收集网页数据,然后对其进行分析,建立索引,以提供相应的接口来对其网页数据进行查询的一套工具。

如何利用nutch和hadoop爬取网页数据

1、向hdfs中存入待抓取的网站url hadoop fs -put urldir urldir 注:第一个urldir为本地文件夹,存放了url数据文件,每行一个url地址 第二个urldir为hdfs的存储路径。

2、大数据时代,要进行数据分析,首先要有数据源,通过爬虫技术可以获得等多的数据源。

3、首先,我们将使用编程语言如Python和其相关的网络爬虫库来获取网页数据。其次,我们也将利用API(应用程序接口)来获取特定类型的数据。

4、数据库用postgresql不是很好。因为爬行结果放在关系型数据库里太吃力。特别是网页内容。通常是URL放在redis里。 内容放在文件系统里,你可以用hadoop+hdfs+thrift方案放在hadoop里。

5、Nutch是为搜索引擎设计的爬虫,大多数用户是需要一个做精准数据爬取(精抽取)的爬虫。Nutch运行的一套流程里,有三分之二是为了搜索引擎而设计的。对精抽取没有太大的意义。

到此,以上就是小编对于hadoop怎么查看hdfs的问题就介绍到这了,希望介绍的几点解答对大家有用,有任何问题和不懂的,欢迎各位老师在评论区讨论,给我留言。

- 1清新职场环境,招聘优秀保洁服务人员

- 2如何选择适合您的玉泉路搬家公司及联系方式

- 3奉贤商城专业保洁服务标准详解

- 4广西玉林邮政社会招聘面试?

- 5大连搬家服务全解析:选择适合您的搬家公司

- 6丰台区搬家服务推荐及联系方式

- 7快速找到厂洼搬家公司电话,轻松搬家无忧

- 8揭秘万寿路搬家公司电话,快速搬家从此不再烦恼

- 9丰台区搬家攻略:选择最适合你的搬家公司

- 10广州长途搬家服务:如何选择合适的搬家公司及其联系方式

- 11木樨地搬家服务全面指南:如何快速找到合适的搬家公司电话

- 12在宣武门找搬家公司?拨打这些电话轻松搬家!

- 13西二旗搬家服务全攻略:如何找到最靠谱的搬家公司电话

- 14临河搬家公司:专业服务助您轻松搬家

- 15选择异地搬家的物流公司,这几点必须考虑!

- 16可靠的十八里店搬家公司:联系电话与服务指南

- 17创造搬家新体验:大众搬家公司官网全揭秘

- 18武汉优质店铺保洁服务,让您的店面焕然一新

- 19青浦物业小区保洁服务的魅力与选择

- 20如何选择合适的保洁服务?美女保洁员的优势与魅力

- 21提升家政服务水平:普陀家政保洁服务培训解析

- 22提升均安诊所环境的保洁服务方案:健康与舒适双重保障

- 23银行保洁服务方案的标准与最佳实践

- 24提升清洁技能,在西藏寻找最佳保洁服务培训学校

- 25让生活更轻松:大型蓝领公寓保洁服务的优势与选择

- 26义乌商贸区保洁服务:为您的商务环境保驾护航

- 27全面解析绿色保洁服务的多种方法

- 28打造洁净空间:武昌大楼日常保洁服务全解析

- 29无锡到上海搬家公司电话推荐:靠谱服务一键直达

- 30辽宁2023年省考公告时间?